Sidebar

λ

第十五课

最优化方法 3

内容

线性规划

非线性优化

主要参考书:

线性规划,张建中,许绍吉,科学出版社

最优化理论与方法,袁亚湘,孙文瑜,科学出版社

二、非线性最优化

引言

最优化的问题的一般形式为

Min f(x)

s.t. x∈X

f(x)为目标函数,X⊂En为可行域。

如X=En,则以上最优化问题为无约束最优化问题。

约束最优化问题通常写为

Min f(x)

s.t. ci(x)=0, i∈E,

ci(x)≥0, i∈I,

其中E, I分别为等式约束的指标集和不等式约束的指标集,ci(x)是约束函数。

1. 无约束非线性最优化

非线性的数据无处不在

1.1 无约束问题的最优条件

min f(x), x∈Rn的最优性条件

局部极小 若存在δ>0,使得对所有满足 || x-x* ||<δ的x, 都有

f(x)>f(x*),

则称x * 为f的局部极小点。

如所有满足 || x-x*||<δ的x,都有f(x)>f( x*),

则称x * 为f的严格局部极小点。

全局极小 若存在δ>0,使得对所有x, 都有f ( x)>=f ( x*),

则称x * 为f的总体极小点。

如所有x,都有f ( x) > f ( x*),

则称x * 为f的严格总体极小点。

min f(x) ,x∈Rn

设g(x)= ∇f(x),G(x)=Δf(x)分别为f的一阶和二阶导数。

定理(一阶必要条件):设f:D⊂Rn→R1在开集D上连续可微, 若x*∈D是局部最小点,则 g(x*)›=0

定理(二阶必要条件):设f:D⊂Rn→R1在开集D上二阶连续可微, 若x*∈D是局部最小点,则 g(x*)=0,G(x*)›=0

1.1 无约束问题的最优条件

g(x*)= 0, 则x称为函数f的平稳点。平稳点有可能是极小点,也可能为极大点,

也可能不是极值点(鞍点)。

定理(二阶充分条件):设f:D⊂Rn→R1在开集D上二阶连续可微,

若x*∈D是严格局部极小点的充分条件是,则g(x*)=0, 且G (x*)为正定矩阵。

定理(凸充分性定理):设f:D⊂Rn→R1是凸函数且一阶连续可微,

若x*是总体极小点的充要条件是g(x*)=0。

什么是凸函数?

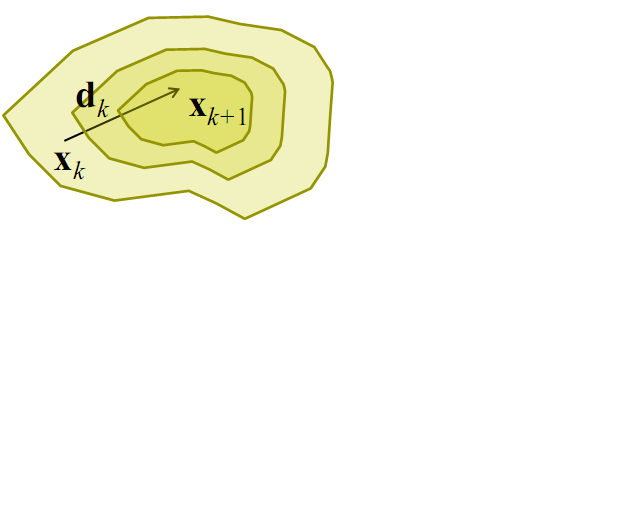

1.2 最优化方法的结构 迭代优化方法的基本思想:

- 给定一个初始点x0,

- 按照某一迭代规则产生一个点列{xk}

- 当{xk}是有穷点列时,其最后一个点是最优化模型问题的最优解。

- 当{xk}是无穷点列时,其极限点为最优解。

一个好的算法应具备的典型特征为:

- 迭代点{xk}能稳定地接近局部极小点x*的邻域,然后迅速收敛于x*

- 当给定的某种收敛准则满足时,迭代即终止。

优化方法的结构

给定初始点x0

1. 确定搜索方向dk,即依照一定规则构造 f 在xk的下降方向为搜索方向

2. 确定步长因子αk,使目标函数值有某种意义下降

3. 令xk+1=xk+αkdk,

a). 若x<sub>k+1</sub>满足某种终止条件,则停止迭代,得到近似最优解,\\

b) 否则,重复以上步骤\\

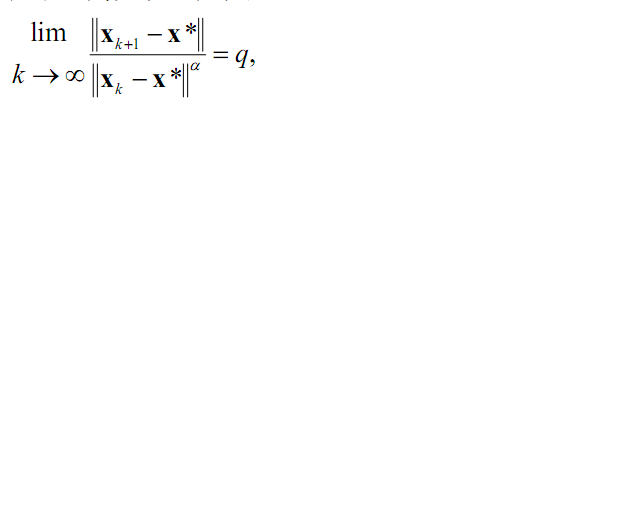

收敛速度

收敛速度也是衡量最优化方法有效性的重要方面。

若存在实数 α及一个与迭代次数k无关的常数q>0,使得

则称算法产生的迭代点列{xk} 具有Q-α 阶收敛速度。特别地

(a)当 α=1,q>0 时,{xk} 具有Q- 线性收敛速度。

(b)当1<α<2,q>0 时 或者 α=1,q=0 , {xk}具有Q- 超线性收敛速度。

(c)当 α=2 ,q>0 时,{xk} 具有Q - 二阶收敛速度。

收敛速度

一般认为,具有超线性和二阶收敛速度的方法是比较快速的。

但对于任何一个算法,收敛线和收敛速度的理论结果并不保证算法在实际执行时一定有好的实际计算结果。

- 忽略了误差;函数计算不满足限制条件

需要选择有代表性的检验函数进行数值计算

一维搜索

单变量函数的最优化。

xk+1=xk+αkdk

其关键就是构造搜索方向dk和步长因子αk,设φ(α)=f(xk+αdk),

这样确定αk,使得φ(α)<φ(0)。这就是关于α的一维搜索问题。

若αk使得目标函数沿方向达到最小,即φ(αk)=minφ(α){s.t α>0},则称这样的

一维搜索为最优一维搜索(或精确一维搜索),αk为最优步长因子。

若取αk使得目标函数得到可以接受的下降量,则成为近似一维搜索,或不精确一维搜索。

实际中,精确的最优步长因子一般不能求到,求几乎精确的最优步长

因子需花费想到大的工作量,因而花费计算量较少的不精确一维搜索受到重视。

一维搜索的主要结构

1.确定包含问题最优解的搜索区间

2.再用某种分割技术或插值方法缩小这个区间,进行搜索求解

搜索区间:包含最优值的闭区间。

确定搜索区间的简单方法——进退法。

从一点出发,试图确定出函数值呈现“高-低-高”的三点。一个方向不成功,就退回来,再沿相反方向寻找。

一维区间搜索的进退法

确定搜索区间的简单方法——进退法。

1.选取初始值α0,h0,加倍系数t>1(一般t=2),k=0;

2.如φ(αk+hk)<φ(αk),则hk+1 = thk,αk+1=αk+hk+1,k++,返回2。

3.若k==0,转换搜索方向hk=-hk ,转2。

否则,停止迭代,输出a=min{α0,αk+1},b=max{α0,αk+1}。

2. 约束非线性最优化

2.1约束优化最优性条件

约束最优化问题通常写成

min f(x)

s.t. ci(x)=0, i⊂E={1,…,me},

ci(x)≥0, i⊂I={me+1,…,m}

在x*处的非积极约束:

设x*为一个局部极小点,若不等式约束i0有,ci0(x*)>0,则可将第i0个约束去掉,且x*仍然是去掉第i0个约束条件的问题的局部极小点。称约束ci0在x*处是非积极的。

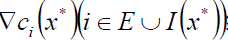

定义:I(x)={i | ci(x)⇐0, i∈I}; A(x)=EUI(x)为x点处的积极集合。

一阶最优性条件

Kuhn-Tucker必要条件:

若x*是问题P的一个局部极小点,如果  线性无关,

线性无关,

则必存在λ*i(i=1,…,m),使得

满足上述两式的点称为K-T点。 与该定理联系密切的是Lagrange函数:

L(x,λ)=f(x)-λTc(x).

则(*)条件等价于∇xL=0。λ称为Lagrange乘子。

二阶必要条件

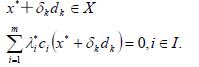

定义:设x*是K-T点,λ*称为相应的Lagrange乘子,托存在序列{dk}和{δk >0}使得

且有dk→d, δk →0,则称d为x*处的序列零约束方向。在x*处的所有序列零约束方向的几何为S(x*,λ*)。

二阶必要性条件:

设x*为局部极小点,λ*称为相应的Lagrange乘子,则必有

dT∇xx2L(x*,λ*)d≥0,∀d⊂S(x*,λ*).

其中L(x,λ)为Lagrange函数。

稍加强可得充分性条件:

设x*为K-T点,λ*称为相应的Lagrange乘子。若

dT∇xx2L(x*,λ*)d>0,∀0≠d⊂S(x*,λ*),则

x*为局部严格极小点。

2.2 可行方向法

可行方向法即要去每次迭代产生的点xk都是约束优化问题的可行点。

关键在于每一步寻找可行下降方向:

dT∇f(xk)<0,d∈FD(xk,X).

可行方向:设x-⊂X,0≠d⊂Rn,如存在δ>0使得x-+td⊂X,则称d为x-处的可行方向。X在x-处的所有可行方向集合记为FD(x-,X)。

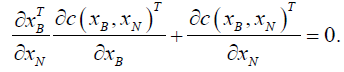

广义消去法

考虑等式约束问题:

min f(x).

s.t. c(x)=0

设有变量分解x=[XB,xN]T,其中xB⊂Rm, xN⊂Rn-m.

则c(x)=0可改写为:

c(xB,xN)=0. (1)

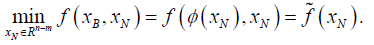

假定可以从(1)解出xB=Φ(xN),则原问题等价于

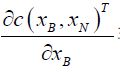

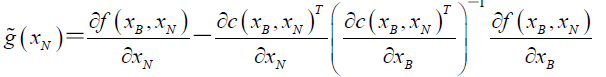

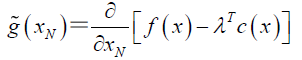

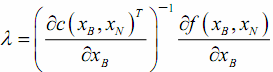

称 为既约梯度。

为既约梯度。

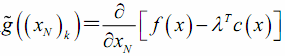

令 ,则发现可以将

,则发现可以将

既约梯度写成Largrange函数在既约空间上的梯度

或者说,有

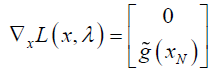

故既约梯度可看作Lagrange函数之梯度的非零部分。利用既约梯度,可以构造无约束优化问题的线搜索方向。

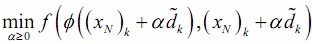

例如可取最速下降方向:

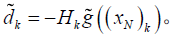

或拟牛顿方向:

在无约束问题上作线性搜索,等价于对原目标函数f(x)在曲线

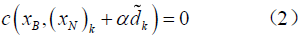

上作曲线搜索。因为Φ(x)的解析表达式并不知道,故作一维搜索时,每个试探步长α>0都要用(2)来求解xB.

上作曲线搜索。因为Φ(x)的解析表达式并不知道,故作一维搜索时,每个试探步长α>0都要用(2)来求解xB.

变量消去法

1.给出可行点x1,ε≥0,k=1

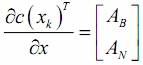

2.计算 ,其中划分使得AB非奇异;

,其中划分使得AB非奇异;

计算 及

及

3.如果 ,则停止;否则利用某种方式产生下降方向

,则停止;否则利用某种方式产生下降方向 ,即使得

,即使得 ;

;

4. 进行线性搜索给出αk >0,令

进行线性搜索给出αk >0,令

转2步。

梯度投影法

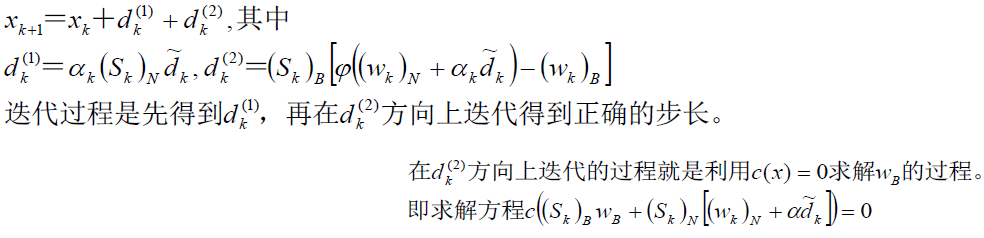

广义消去法每次迭代的变量增量由xk+1-xk两部分组成,

- Unordered List Item迭代方式存在不合理之处。本来希望迭代点都在可行域上,但具体迭代过程却是先远离可行域,然后再校正回可行域中。

- Unordered List Item希望离开程度尽可能小?沿线性化方向。迭代过程可以更快的收敛。