近日,浙江大学计算机辅助设计与图形系统全国重点实验室周昆教授课题组在SIGGRAPH 2025会议上,发表名为“When Gaussian Meets Surfel: Ultra-fast High-fidelity Radiance Field Rendering”的研究论文,提出一种名为高斯增强面元(Gaussian-enhanced Surfels, GESs)的双尺度辐射场表示方法,通过结合不透明二维面元与三维高斯的混合建模,在渲染速度与多视角一致性上取得突破性进展。该研究为实时高保真三维重建与渲染提供了全新的技术路径。

研究背景

三维重建与渲染是计算机图形学与三维视觉的热点问题。以多视角图像为输入,基于图像的重建算法完成场景重建后即可实现从自由视角渲染场景图像。早期传统方法如Light field通过密集采样图像构建场景的辐射分布。然而,其对输入图像的密集性和几何重建的依赖性高,难以扩展到复杂场景。神经辐射场(NeRF)通过MLP隐式建模场景的体积密度和辐射度,实现了高质量的自由视角合成,但由于其依赖神经网络的体积渲染,因此训练与渲染效率低下。近年来,三维高斯泼溅(3DGS)通过三维高斯的可微光栅化实现了实时渲染,但其依赖全局排序的颜色混合策略导致视角不一致性(如“闪烁伪影”),后续工作如2DGS改用二维高斯提升几何一致性,StopThePop通过优化排序策略提升视角一致性,但均未彻底解决视角一致性问题。

研究创新与突破

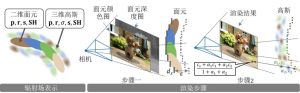

本研究提出了一种辐射场的新颖表示与绘制和重建方法。本研究使用高斯增强面元作为辐射场的表示,在粗粒度下,一组具有视角相关颜色的二维不透明椭圆形面元构成了场景表面辐射场的近似表示,每个二维面元是定义在局部坐标系中位于 XY 平面上的单位圆盘;在细粒度下,一些围绕在不透明面元的附近的三维高斯形成了一个体积辐射场,用于补充表面辐射场未能良好表示的场景外观信息。对于给定的视角,首先通过标准图形管线对不透明面元进行光栅化,生成颜色和深度图。然后将三维高斯投影到屏幕空间并执行深度测试,并在面元渲染出的颜色图的每个像素上根据高斯的不透明度顺序无关的加权累积高斯的颜色,得到最终的渲染结果。本方法还提出了由粗粒度到细粒度的优化流程,在粗粒度优化阶段,优化不透明面元,以重建粗粒度的几何结构和外观;在细粒度优化阶段,固定面元的几何属性,引入三维高斯联合优化。此外,本研究方法提出的新颖表示可以与现有方法结合形成拓展方法,以实现抗锯齿渲染、进一步提升渲染速度、减少存储开销,并可以通过用二维高斯替换三维高斯来重建更精确的场景几何。

本方法的辐射场表示与渲染流程图

研究成果与贡献

与现有方法相比,本研究方法能以极高的渲染速度合成出高质量的、满足视觉一致性的新视角图像与视频。

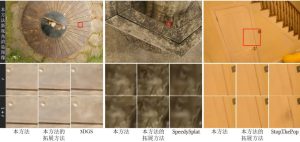

以上是本方法与其他方法在新视角合成任务上的对比结果,本方法能实现高保真的细节保留的新视角图像合成。

以上是本方法与其他方法在新视角合成任务上的对比结果,本方法能实现高保真的细节保留的新视角图像合成。

以上是本方法与其他方法在视角一致性上的对比,当相机视角发生微量旋转后(由t时刻移动到t+1时刻),本方法与本方法的拓展方法均保持了视角一致性,而其他对比方法出现了突然“跳出”的高斯颜色。

以上是本方法与其他方法在视角一致性上的对比,当相机视角发生微量旋转后(由t时刻移动到t+1时刻),本方法与本方法的拓展方法均保持了视角一致性,而其他对比方法出现了突然“跳出”的高斯颜色。

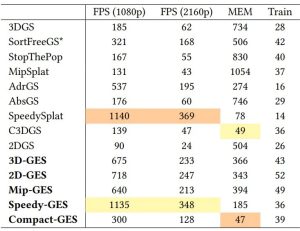

本研究方法及其扩展方法(加粗部分)与其他方法在1080p与2160p分辨率下的渲染帧率、存储空间开销(单位:MB)与训练耗时(单位:分钟)的对比。

本研究方法及其扩展方法(加粗部分)与其他方法在1080p与2160p分辨率下的渲染帧率、存储空间开销(单位:MB)与训练耗时(单位:分钟)的对比。

浙江大学计算机辅助设计与图形系统全国重点实验室周昆教授为本文通讯作者;博士研究生叶可扬为本文第一作者。本研究受到国家自然科学基金(编号:62421003, 62227806 与 U23A20311)与科学探索奖的资助。