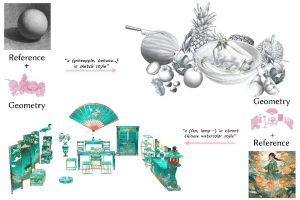

近期,浙江大学计算机辅助设计与图形系统全国重点实验室金小刚教授课题组的研究论文《StyleTex: Style Image-Guided Texture Generation for 3D Models》被Siggraph Asia 2024录用,并将发表在《ACM Transactions on Graphics》期刊上。该论文提出了一种基于扩散模型的风格化纹理生成框架,能够有效地从参考图像中提取风格信息,并将其应用于3D模型,从而生成更加一致且高质量的纹理效果。这项研究在基于扩散模型的3D纹理生成领域实现了重要的创新突破,为风格化的游戏与电影制作提供了全新的技术解决方案。