Monocular Depth Estimation

1. 项目简介

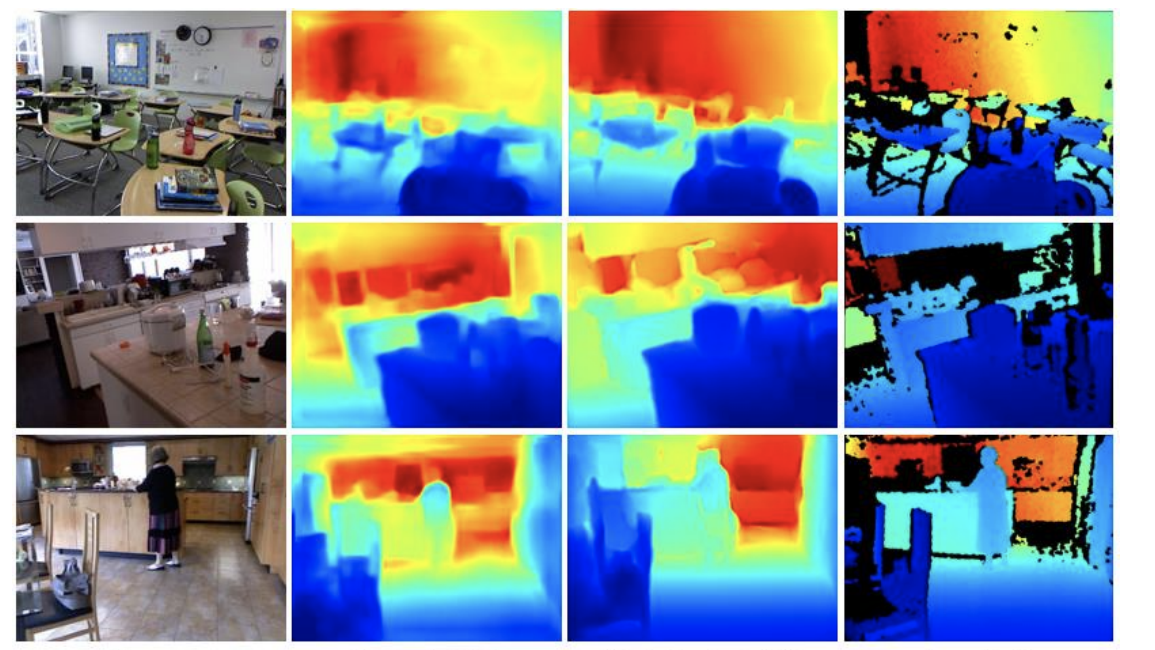

深度估计是三维场景理解的重要组成部分。 其中,一个具有挑战性的任务是依靠单目图像来实现场景深度估计。 单目深度估计问题虽然是一个相当病态的问题,但在一些特定场景下是可以解决的。 近年来,由于深度神经网络的发展,许多工作尝试以监督学习的方式来解决单目深度估计问题。 其中,绝大多数工作通过卷积神经网络(CNN)将其表述为像素级的回归问题,并取得了一定的成果。这些工作大部分集中在设计更好的网络结构,损失函数以及附加的后处理步骤上。

2. 实验要求

在此项目中,我们计划使用NYU Depth V2数据集从单目图像估计深度,该数据集总共包含1449个图像深度对,可以在这里找到。 在最常见的设置下,用于训练的样本为795个,用于测试的样本为654,可以在这里下载正式的训练/测试分割。 当然,795个样本通常不足以让网络达到完美的收敛结果。为了改善效果,您可以使用从NYU Depth V2原始数据集中采样更多的图像深度对进行训练,但也应遵循官方的训练/测试划分。 具体而言,你需要将来自split.mat的索引和nyu_depth_v2_labeled.mat的场景结合起来,以此来获得249个用于训练的场景和215个用于测试的场景。 为了减轻不必要的负担,你可以使用一些开源代码进行数据集的预处理和加载。

必做项

- 实现单目图像深度估计,并根据Eigen等人[1]或者是Laina等人[3]的评估标准对网络的性能进行评估。

- 实现一个用户界面,用于交互式的选取图像进行深度估计,并保存到用户指定的目录。

加分项(个人做可以加分,团队做必选其中2项)

- 提升单目图像估计的精度(例如:使用语义信息或者是同步估计语义分割、法向图等方法提升边缘的锐利程度)(最多4分)

- 利用原始的RGB图像和估计的深度图,尝试生成带纹理贴图的物体三维模型或者是场景Mesh(最多4分)

- 想办法加速网络的推断(最多3分)

- 借助多视角一致性,使用自监督的方法进行深度估计的训练(可以参考[5] ;你需要一个带pose的数据集,例如KITTI或者TUM-RGBD)。(最多5分)

我们对最终性能没有太大的要求,所以不要简单地重新实现现有的论文,而应该向我们展示你尝试解决问题的原创性探索。

参考文献

[1] D. Eigen, C. Puhrsch, and R. Fergus. Depth map prediction from a single image using a multi-scale deep network. In Advances in neural information processing systems, pages 2366–2374, 2014.

[2] D. Eigen and R. Fergus. Predicting depth, surface normal and semantic labels with a common multi-scale convolutional architecture. In Proceedings of the IEEE International Conference on Computer Vision, pages 2650–2658, 2015.

[3] Laina I, Rupprecht C, Belagiannis V, et al. Deeper depth prediction with fully convolutional residual networks[C]//2016 Fourth international conference on 3D vision (3DV). IEEE, 2016: 239-248.

[4] Liu C, Gu J, Kim K, et al. Neural RGB ( r ) D Sensing: Depth and Uncertainty From a Video Camera[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2019: 10986-10995.

[5] Zhou T, Brown M, Snavely N, et al. Unsupervised learning of depth and ego-motion from video[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 1851-1858.