浙江大学计算机辅助设计与图形系统全国重点实验室邵天甲研究员课题组在CVPR 2025会议上,在线发表名为“High-fidelity 3D Object Generation from Single Image with RGBN-Volume Gaussian Reconstruction Model”的研究论文,并被评为Highlight论文。该研究通过一种创新的体素-高斯混合表示方法以便进行三维结构化表征学习,以及一个独特的特征融合机制对二维图像中估算所得到的RGB图像特征和表面法线特征进行精确对齐。课题组所提出的GS-RGBN三维物体生成框架,能够使用单张图像生成高质量的三维物体,为三维物体生成系统的开发提供了新的设计思路。

研究背景

从二维图像生成三维资产在虚拟现实(VR)、增强现实(AR)、工业设计、游戏和动画等领域具有重要的应用价值。近期,作为该领域的一个重要子课题,仅基于单张图像生成具备高质量形状与纹理的三维物体成为研究热点。然而,由于单视图图像本身存在固有的几何模糊性以及信息不足的问题,这一任务仍面临诸多挑战。

新兴的多视图扩散模型为缓解上述信息稀缺问题提供了一种潜在的技术路径。这些模型通过将单张图像扩展为多视图图像,从而为三维物体生成提供了更全面的视角信息。开创性研究如Dreamfusion及其后续工作引入了分数蒸馏采样方法及其变体,直接利用预训练的多视图扩散模型生成的多视图图像(或其隐含的三维先验知识)来优化三维参数化模型。然而,这些生成的多视图图像在不同视角之间存在显著的不一致性,导致生成的三维物体也面临视图不一致的问题。为解决这一挑战,另一类方法(例如Wonder3D等)通过引入额外的信息源,如相机嵌入、文本嵌入以及对极几何约束,对预训练的多视图扩散模型进行微调。尽管经过改进,微调后的多视图图像仍难以满足直接重建具有高度一致细节的三维模型的需求。此外,针对每个物体的逐形状优化过程通常需要数千次迭代,显著降低了三维重建的速度与效率。基于此,一个关键问题随之浮现:是否可以设计一种端到端的神经网络架构,使其能够直接从不一致的多视图图像中学习,并在无需依赖复杂优化迭代的情况下生成视图一致的三维物体? 为了回答这一问题,近期由大型端到端重建模型(LRM)引领的范式引入了多种神经网络架构(例如Transformer和U-Net),其能够直接从不一致的多视角图像中学习并生成三维模型。随后,生成的三维模型被用于渲染每个视角的图像,并通过比较渲染图像与真实图像之间的差异(即渲染损失)以监督训练过程。此外三维高斯模型因其在新视角合成中的卓越质量和高效的渲染速度,已成为端到端重建模型的主要三维表示形式,逐渐取代了诸如神经辐射场(NeRF)等传统三维表示形式。然而,由于三维高斯的空间非结构化特性以及所输入二维RGB图像中固有的几何模糊性,直接从二维图像中学习三维高斯分布以生成高质量的物体仍然面临挑战,其导致生成的三维物体出现扭曲或模糊的现象。

研究创新与突破

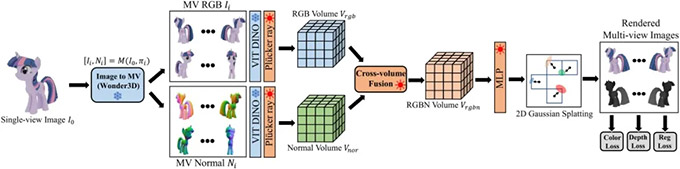

本研究提出 GS-RGBN,一种创新的体素-高斯重建模型,能够在几秒钟内实现三维物体的快速且高质量渲染与重建。GS-RGBN 主要实现了以下两个关键创新点:首先,传统方法通常依赖二维卷积对图像特征进行编码,并在二维平面中解码逐像素的三维高斯属性。相比之下,我们设计了一种新颖的体素-高斯混合模型,其中每个高斯分布被限制在一个体素网格内,而每个体素则包含投影后的二维图像特征。通过这种方式,该模型能够建立每个高斯的三维位置与其对应的二维投影图像特征之间的空间对应关系,从而利用标准三维卷积高效捕捉相邻高斯之间的相关性,以支持可泛化的三维表示学习。其次,法线信息为恢复复杂几何细节提供了重要的线索,而这些细节在以往仅基于 RGB 图像的三维重建方法中往往因固有的几何模糊性而丢失。因此,我们引入了一个简单但高效的特征融合模块,该模块通过多个交叉注意力机制充分利用来自 RGB 图像和法线图像的互补语义及几何信息进行特征级融合,从而显著增强重建物体的几何复杂性。此外,我们选择使用二维高斯分布而非广泛采用的三维高斯分来作为三维表示的核心,其不仅确保了几何表示的一致性,还实现了对表面的内在建模。综上,本研究作出以下贡献:

・一种创新的体素-高斯重建模型(GS-RGBN),该模型能够在几秒钟内从单视图图像生成高质量的三维资产;

・一种混合体素-高斯模型,通过结构化的三维体素网格表示为非结构化高斯的通用三维特征学习提供了有效的解决方案;

・一个简单而高效的特征融合模块,用于在特征层面实现RGB和法线信息的深度融合,从而恢复具有高保真度的几何形状。

本方法系统框架示意图

研究成果与贡献

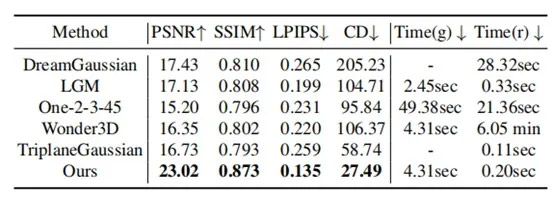

本研究方法能够通过单张图片生成高质量的三维物体,下面介绍本研究生成的结果以及其他方法的对比。

上图中展示了所生成的三维物体的定性比较。在所有视图合成指标方面,我们的方法相较于近期的其他方法展现出显著的优势。

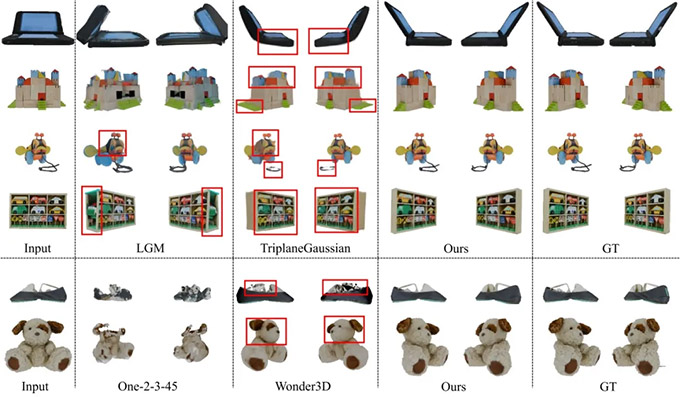

上图展示了我们的方法和其它方法所生成的三维物体对比图。我们的方法所重建的三维物体不仅质量高,而且细节连贯清晰。

浙江大学计算机辅助设计与图形系统全国重点实验室邵天甲研究员为本文通讯作者;博士研究生申一杨为本文的第一作者。本研究受到了国家自然科学基金(编号:U23A20311,62322209和62421003)、科学探索奖、Adobe Research和浙大百人计划的资助。